Tutto quello che c’è da sapere su Google Bert

Il nuovo update dell’algoritmo nella ricerca di Google: cos’è, come funziona e cosa cambierà per la ricerca.

Google ha affermato che il nuovo aggiornamento dell’algoritmo di ricerca principale più recente, Google BERT, aiuterà a comprendere meglio l’intento alla base delle query di ricerca degli utenti, comportando di conseguenza comportare risultati più pertinenti.

BERT avrà un impatto sul 10% delle ricerche, ha affermato la società, il che significa che probabilmente impatterà sulla visibilità organica e sul traffico del tuo marchio, potrebbe eh!

Questo è ciò che pensiamo su quello che Google sta pubblicizzando come “uno dei più grandi passi avanti nella storia della ricerca“.

Da quando è attivo BERT nella ricerca di Google?

Il roll-out di BERT nel sistema di ricerca di Google è stato implementato la settimana del 21 ottobre 2019 solamente per le query in lingua inglese, inclusi i featured snippets in primo piano.

L’algoritmo si espanderà in tutte le lingue in cui Google offre la ricerca, ma non esiste ancora un calendario ben definito, ha affermato Danny Sullivan di Google. Un modello di Google BERT viene anche utilizzato per migliorare i featured snippets in primo piano in una ventina di paesi.

Che cos’è quindi Google BERT?

BERT, acronimo di “Bidirectional Encoder Representations from Transformers“, è una tecnica basata sulle reti neurali per il pre-training sull’elaborazione del linguaggio naturale. In parole povere, può essere utilizzato per aiutare Google a discernere meglio il contesto delle parole in base alla query di ricerca.

Ad esempio, nelle frasi “nine to five” e “a quarter to five”, la parola “to” ha due significati diversi, che possono essere ovvi per gli umani ma meno per i motori di ricerca. BERT è progettato per distinguere tra tali sfumature per facilitare risultati più pertinenti.

Google ha rilasciato i sorgenti di BERT nel novembre del 2018. Questo significa che chiunque può utilizzare BERT per addestrare il proprio sistema di elaborazione della lingua per rispondere alle domande o ad altre attività.

Cos’è una rete neurale?

Semplificando molto questa definizione, le reti neurali di algoritmi sono progettate per il riconoscimento di schemi. La categorizzazione del contenuto dell’immagine, il riconoscimento della calligrafia e persino la previsione delle tendenze nei mercati finanziari sono applicazioni comuni del mondo reale per le reti neurali, per non parlare delle applicazioni di ricerca come i modelli di click.

Le reti neurali si “allenano” su infiniti set di dati per poter riconoscere dei modelli. Google ha affermato che BERT è stato pre-addestrato utilizzando il corpo del testo in chiaro presente su Wikipedia.

Cos’è l’elaborazione del linguaggio naturale?

L’elaborazione del linguaggio naturale (PNL) si riferisce a un ramo dell’intelligenza artificiale AI che si occupa della linguistica, con l’obiettivo di consentire ai computer di comprendere il modo in cui gli umani comunicano naturalmente.

Alcuni esempi di applicazioni resi possibili dalla PNL possono essere strumenti di social listening, chatbot e i suggerimenti di parole nelle app delle tastiere sullo smartphone.

Di per sé, però, la PNL non è una nuova funzionalità per i motori di ricerca. BERT, tuttavia, rappresenta un progresso nella PNL attraverso la formazione bidirezionale.

Come funziona BERT?

La svolta di BERT sta nella sua capacità di formare modelli linguistici basati sull’intero insieme di parole in una frase o query (addestramento bidirezionale) piuttosto che sul modo tradizionale di allenamento sulla sequenza ordinata di parole (da sinistra a destra o combinata a sinistra da destra a sinistra e da destra a sinistra).

BERT consente al modello linguistico di apprendere il contesto delle parole in base alle parole circostanti anziché solo alla parola che precede o segue immediatamente.

Google afferma che BERT è “deeply bidirectional” o “bidirezionale profondo”, poiché le rappresentazioni contestuali delle parole iniziano “dal fondo di una rete neurale profonda”.

“Ad esempio, la parola “bank” avrebbe la stessa rappresentazione priva di contesto in “bank account“e “bank of the river“. I modelli contestuali generano invece una rappresentazione di ogni parola basata sulle altre parole della frase. Ad esempio, nella frase “I accessed the bank account“, un modello contestuale unidirezionale rappresenterebbe “bank” in base a “I accessed the” ma non “account“. Tuttavia, BERT rappresenta “bank” usando sia il suo contesto precedente che successivo “I accessed the … account. ”.

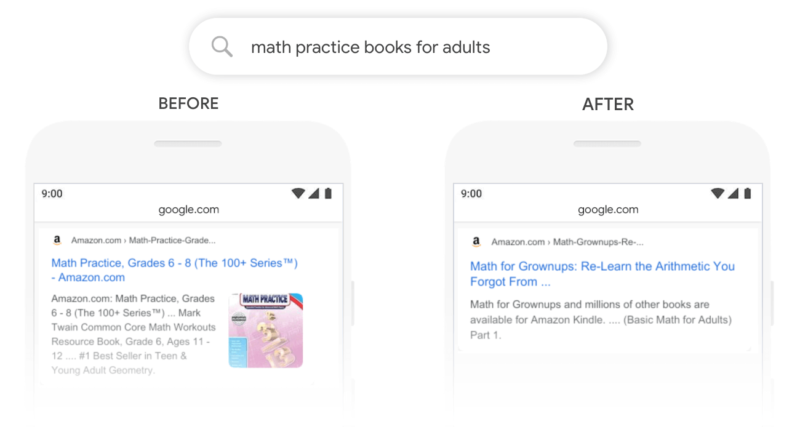

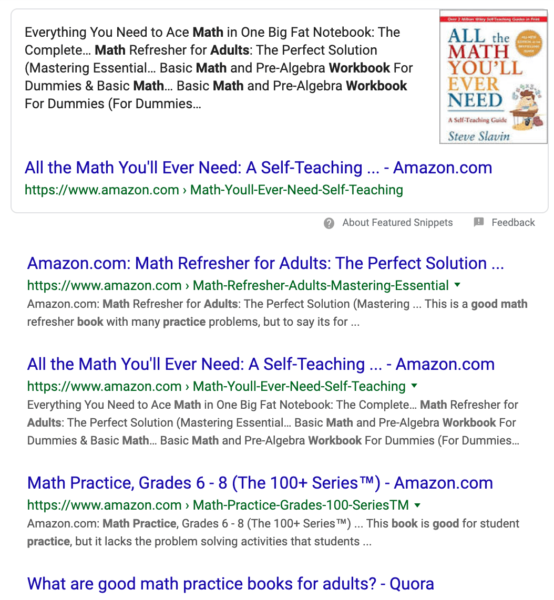

Google ha mostrato diversi esempi su come l’algoritmo BERT può influire sui risultati di ricerca. Per fare un esempio, prima dell’introduzione di Bert, nella query di ricerca “math practice books for adults” emergeva nella parte superiore dei risultati organici una lista di libri per le scuole Grades 6-8. Dopo BERT, Google presenta invece il libro intitolato “Math for Grownups” nella parte superiore dei risultati.

Si può vedere che attualmente la lista di libri per le scuole Grades 6-8 è ancora nella prima pagina dei risultati, ma ci sono due libri, specificamente rivolti agli adulti, che ora si posizionano al di sopra di esso, incluso nello snippet in primo piano.

Un cambiamento nei risultati di ricerca come quello sopra riflette la nuova comprensione della query tramite BERT. I contenuti per i Youth Adults non vengono penalizzati, ma gli elenchi specifici per gli adulti saranno più allineati con l’intento di chi ricerca.

Google utilizza BERT per dare un senso a tutte le ricerche?

No, non esattamente. BERT migliorerà la comprensione di Google di circa una ricerca su 10 per la lingua inglese negli Stati Uniti (per oggi, novembre 2019).

“In particolare, per query più lunghe e più conversazionali o ricerche in cui preposizioni come “for” e “to” contano molto sul significato, la ricerca sarà in grado di comprendere il contesto delle parole nella query”, ha affermato Google stessa nel loro post sul blog ufficiale.

Tuttavia, non tutte le query sono conversazionali o includono preposizioni. Ricerche sui marchi e frasi più brevi sono solo due esempi di tipi di query che potrebbero non richiedere l’elaborazione del linguaggio naturale di BERT.

In che modo BERT avrà un impatto sui miei featured snippet in primo piano?

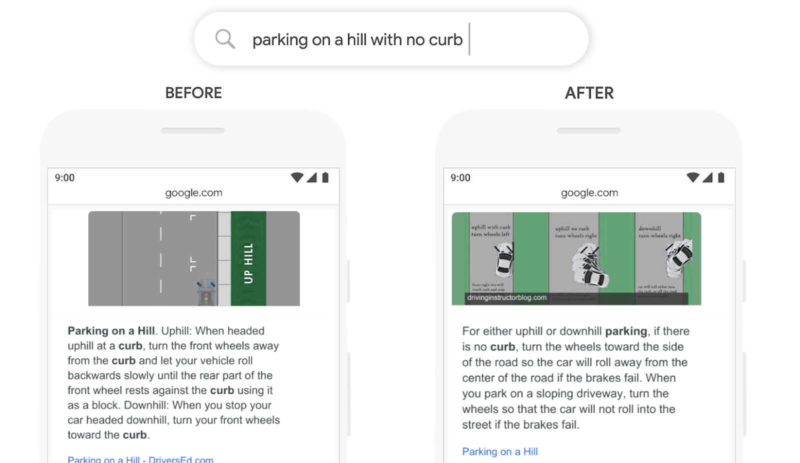

Come abbiamo visto nell’esempio sopra, BERT può influire sui risultati che compaiono negli snippet in primo piano quando viene applicato.

In un altro esempio, Google confronta gli snippet in primo piano per la query “parking on a hill with no curb”, spiegando così: “In passato, una query come questa avrebbe confuso i nostri sistemi – abbiamo dato troppa importanza alla parola “marciapiede” e ignorato la parola “no”, non capendo quanto fosse cruciale quella parola per rispondere adeguatamente a questa domanda. Quindi restituiremmo i risultati per il parcheggio su una collina con un marciapiede.”

Qual è la differenza tra BERT e RankBrain?

Alcune delle funzionalità di BERT potrebbero sembrare simili al primo metodo di intelligenza artificiale di Google per la comprensione delle query, RankBrain. Tuttavia, sono due algoritmi separati che possono essere utilizzati per informare i risultati della ricerca.

“La prima cosa da capire su RankBrain è che funziona in parallelo con i normali algoritmi di classificazione delle ricerche organiche e viene utilizzato per apportare modifiche ai risultati calcolati da tali algoritmi”, ha affermato Eric Enge, direttore generale di Perficient Digital.

RankBrain regola i risultati osservando la query corrente e trovando query molto simili. Quindi, esamina le prestazioni dei risultati della ricerca per quelle query storiche. “In base a ciò che vede, RankBrain può regolare l’output dei risultati dei normali algoritmi di classificazione delle ricerche organiche”, ha affermato Enge.

RankBrain aiuta anche Google a interpretare le query di ricerca in modo che possa mostrare risultati che potrebbero non contenere le parole esatte nella query. Nell’esempio seguente, Google è stato in grado di capire che l’utente stava cercando informazioni sulla Torre Eiffel, nonostante il nome della torre non comparisse nella query “height of the landmark in Paris”.

“BERT opera in modo completamente diverso“, ha affermato Enge. “Gli algoritmi tradizionali provano a guardare il contenuto di una pagina per capire di cosa si tratta e a cosa potrebbe essere rilevante. Tuttavia, gli algoritmi NPL tradizionali sono in grado di guardare il contenuto prima di una parola o il contenuto dopo una parola in base a contesti aggiuntivi per capire meglio il significato di quella parola.

La componente bidirezionale di BERT è ciò che lo rende diverso. ”Come accennato in precedenza, BERT esamina il contenuto prima e dopo una parola per migliorare la sua comprensione del significato e della pertinenza di quella parola. “Questo è un miglioramento fondamentale nell’elaborazione del linguaggio naturale poiché la comunicazione umana è naturalmente stratificata e complessa”.

Sia BERT che RankBrain sono utilizzati da Google per elaborare query e contenuti delle pagine Web e per comprendere meglio il significato delle parole.

BERT non è arrivato per sostituire RankBrain. Google può utilizzare più metodi per comprendere una query, il che significa che BERT potrebbe essere applicato o meno da solo, insieme ad altri algoritmi di Google, insieme a RankBrain o qualsiasi altra combinazione, a seconda del termine di ricerca.

Quali altri prodotti Google potrebbero influenzare BERT?

L’annuncio di Google per BERT riguarda solo la ricerca, tuttavia avrà un impatto anche sull’Assistente Google. Quando le query condotte su Google Assistant lo attivano per fornire snippet in primo piano o risultati Web dalla ricerca, tali risultati potrebbero essere influenzati da Google BERT.

Google ha detto al Search Engine Land che BERT non è attualmente utilizzato per gli annunci di Google Ads, ma se mai verrà integrato in futuro, potrebbe aiutare ad prevenire alcuni problemi causati dalle varianti delle keyword simili che tanto affliggono gli inserzionisti.

“Come posso ottimizzare il mio sito per Google BERT?”

“Non c’è niente da fare per ottimizzare per Google BERT, né niente che è da ripensare”, ha dichiarato Danny Sullivan.

Il consiglio di Google di ottimizzare i propri contenuti è stato costantemente quello far tenere bene a mente all’utente di creare contenuti che soddisfino le intenzioni di ricerca. Poiché BERT è progettato per interpretare tale intento, il consiglio di Google rimane sempre lo stesso!

“Ottimizzare” ora significa che ci si potrà concentrare maggiormente sulla scrittura chiara e corretta, invece di scendere a compromessi tra la creazione di contenuti per il tuo pubblico e la costruzione del fraseggio lineare per le macchine.